لن تتمكن من تمثيل نفسك في المحكمة بمساعدة ChatGPT صباح الغد. في تجربة أُجريت في مدرسة École du Barreau بتحريض من La Presse ، فشل روبوت محادثة OpenAI فشلاً ذريعًا في امتحان شريط كيبيك ، وحصل على درجة نهائية قدرها 12٪.

تم تقديم الفحص إلى الروبوت (إصدار GPT4) مع تعليمات محددة. تم إخباره بوضوح بسياق الأسئلة والنصوص القانونية التي كان عليه الرجوع إليها للإجابة عليها وطبيعة الإجابات المتوقعة. مع كل إجابة ، قيل له إنه يتعين عليه الاستشهاد بمواد قانونية معينة لدعم وجهة نظره. كثيرًا ما عُرض عليه الفرصة لإعادة صياغة إجاباته بمبادئ توجيهية أكثر تحديدًا. كانت الأسئلة جزءًا من اختبار قديم يستخدمه الطلاب للتحضير للاختبار الحقيقي.

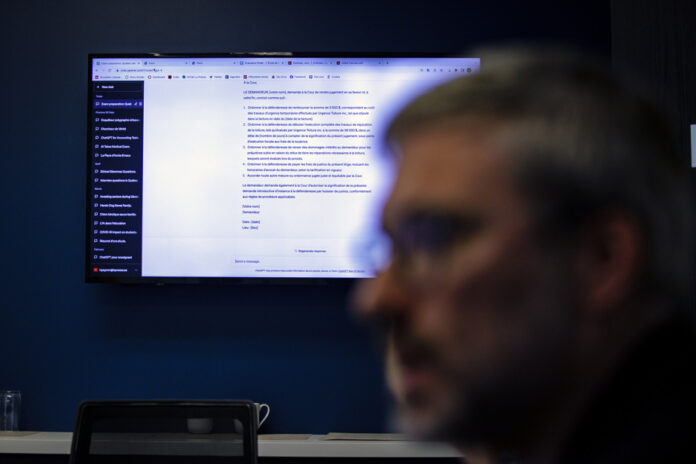

مباشرة ، مع عرض ردود ChatGPT على شاشة كبيرة ، قامت Me Jocelyne Tremblay ، مستشارة إدارة مدرسة École du Barreau du Québec (EBQ) ، و Me Brigitte Deslandes ، مديرة التقييم ، بتقييم ردود الروبوت ، موضحًا لـ La Presse سبب قيام الروبوت تم تصنيف الإجابات بدرجة عالية … أم لا. وحضر الاجتماع أيضًا مدير المعهد الموسيقي ، أنا جاي فرانسوا لامي.

القسم الأول: الأخلاق. يستحضر السيناريو علاقة محامي وموكل حيث يرتكب محام وهمي انتهاكات لقواعد الأخلاق. السؤال: اذكر عيوب المحامي العشر. من هذا السؤال الأول ، يتعثر ChatGPT. مواد مدونة الأخلاق التي اقتبسها غير دقيقة. “في الواقع ، ليست أي من المقالات المقتبسة دقيقة. ويشير Me Deslandes إلى أنه في بعض النقاط القانونية ، فهو حقًا في الميدان.

بعض عيوب المحامي التي تم إبرازها صحيحة ، ولكن … لكن ChatGPT لا تعتمد على المادة الصحيحة من مدونة الأخلاق. وفي بعض الأحيان ، تكون المعلومات التي يقدمها الروبوت “خاطئة تمامًا” ، هذا ما يؤكده تريمبلاي.

نمنح ChatGPT فرصة ، ونحدد مرة أخرى أننا نشير إلى إصدار 2015 من مدونة أخلاقيات المحامين في كيبيك. يطلب منهم إعادة صياغة الإجابة. “هذا ليس أفضل. نحن لسنا هناك على الإطلاق ، “القاضي لي لامي.

يسجل هذا السؤال الأول: صفر.

تتمة في الحفاظ. غالبًا ما تظل ChatGPT في العموميات ، حتى عندما يُطلب منها تحديد إجاباتها. وأحيانًا يحصل على إجابة خاطئة تمامًا: فيما يتعلق بسؤال الامتياز هذا ، فهو بعيد كل البعد عن الصواب. يقول لامي: “أحيانًا يقول عكس الواقع”.

قسم الأخلاقيات: درجة صفر في جميع الأسئلة المقالية الخمسة.

الروبوت ليس أفضل حالًا في القسم التالي ، الذي يغطي جوانب مختلفة من القانون. بالنسبة للسؤال الأول ، تم إخبار ChatGPT على وجه التحديد أن السؤال يشير إلى قانون الالتزامات المعمول به في كيبيك. السؤال يتعلق باستئجار كوخ وتوقيع عقد إيجار. تبين أن المشورة القانونية للروبوت خاطئة.

قال لي ترمبلاي: “هذه هي الإجابة الخاطئة”. إنه ليس حتى في القسم الصحيح من القانون المدني لكيبيك. باختصار ، إنه في الميدان تمامًا. السؤال الثاني يتناول نفس السيناريو ، مع معلومات إضافية. هذه المرة ، يستشهد الروبوت بمقالات تتعلق بالموت “بينما لم يمت أحد في هذه القصة!” قال السيد ترمبلاي.

خلال هذا القسم ، يقترب التحليل القانوني للروبوت أحيانًا من الواقع ، لاحظ المقيّمين على أي حال. ويضيف لامي: “لكنه يرد كطالب أكثر من كونه محاميًا في المستقبل”. وكطالب ليس جيدًا جدًا ، لأنه غالبًا ما يخطئ في مادة القانون. ومع ذلك ، فإن الروبوت ممتاز في إلقاء الدخان في العين ، كما يشير مدير EBQ. “يبدو أنه محام. لكن الإجابات المقدمة غالبًا ما تكون خاطئة. »

النتيجة للقسم الثاني من الامتحان ، بما في ذلك سؤال حول كتابة الطلب الأصلي – محاكمة ، باللغة الفرنسية الجيدة: صفر. سوف يربح ChatGPT نقاطه الوحيدة من الامتحان بأكمله في قسم الاختيار من متعدد. في المجموع ، حصل على علامة 12٪. “بعض الطلاب يفشلون ، لكن ما رأيناه للتو شديد كأداء ضعيف” ، قالت لي لامي.

نظرًا لشعبية روبوت OpenAI ، يعتبر مدير EBQ الوضع مقلقًا من حيث الحماية العامة. قال السيد لامي: “سأخشى على مواطن يختار تمثيل نفسه بمساعدة الروبوت”.

ومع ذلك ، تم إجراء تجارب مماثلة في الولايات المتحدة. هناك ، كان ChatGPT قد تألق في امتحان American Bar ، وحصل على علامة من شأنها أن تضعه في أعلى 10٪ من الطلاب. تدعي شركة OpenAI أيضًا أن روبوتها احتل المرتبة الأولى في 10٪ من الدرجات في العديد من الاختبارات القانونية. كيف نفسر هذه الفجوة؟

أولاً ، يتم إجراء هذه الاختبارات باستخدام بروتوكول دقيق للغاية ، وهذا ليس هو الحال مع تجربة لابريس الأكثر “حرفية” ، كما يشير ديف أنكتيل ، أستاذ الفلسفة في كوليج جان دي بريبوف والباحث المنتسب إلى المرصد الدولي التأثيرات المجتمعية للذكاء الاصطناعي والرقمي في جامعة لافال. في ظل الظروف المثلى ، قد يكون الروبوت قد زاد من تقييمه. “عليك أن تكون حذرًا في هذا النوع من الاختبارات الحرفية. »

ومع ذلك ، فإن المشكلة الرئيسية تأتي من حقيقة أن الروبوت يتم تغذيته بالقانون الأمريكي أكثر من قانون كيبيك. يقول أنتتيل: “لديه معرفة هامشية بالقانون الكندي”. إنها مثل مطالبة محام أمريكي بممارسة القانون المدني في كيبيك. »

يضيف لوران شارلين ، الأستاذ المشارك في مدرسة الدراسات العليا التجارية (HEC) في جامعة مونتريال وعضو كرسي كندا في الذكاء الاصطناعي: “لديه حق الوصول إلى الكثير والكثير من المواد الأمريكية”.

بالإضافة إلى ذلك ، يلاحظ Anctil أن شركة OpenAI تتطلع في النهاية إلى بيع إصدارات أكثر تخصصًا من chatbot الخاص بها. “نظرًا لأن الولايات المتحدة تتحدث مع نفسها كثيرًا ، كانت الشركة تعلم أن النموذج سيتم اختباره في الولايات المتحدة. لذلك صممناه ليقدم أداءً جيدًا في هذا البلد. الفكرة هي جذب العملاء المحتملين ، الذين يرغبون في الحصول على نسختهم الخاصة من الروبوت لمزيد من الموضوعات المتخصصة.

وفي المسائل القانونية ، بدأت الثورة بالفعل ، يؤكد ديف أنتتيل. “لا ينبغي طمأنة المحامين من خلال اختبارك. إنهم يخاطرون بالسقوط من مقاعدهم هذا العام. يتم حاليًا تدريب النماذج ، وسنكون قادرين على استبدال آلاف الساعات من البحث التي يجريها حاليًا مساعدون قانونيون بالذكاء الاصطناعي. »

“عندما ظهرت ويكيبيديا ، قال محررو العديد من الموسوعات العظيمة لأنفسهم: إنها لن تحل محلنا أبدًا ، كما يلاحظ لوران شارلين. بعد سنوات ، تستخدم ويكيبيديا الآن كمرجع موثوق به إلى حد ما. سوف يتبع الذكاء الاصطناعي نفس المسار بالضبط. »

قدمت La Presse نفس الطلب لأربعة طلبات مهنية: دع ChatGPT يجتاز اختبار القبول وتقييم إجابات الروبوت. رفض كل من نقابة المهندسين ونقابة المحاسبين وكلية أطباء الأسرة في كندا (CCFFC) المشاركة في التجربة ، بدعوى سرية أسئلة الامتحان الخاصة بهم. وافق البار فقط على تجربة التجربة. ومع ذلك ، فقد قيل لنا في CCFMC أنهم قد “اختبروا” بعض أسئلة الممارسة على ChatGPT. يقول الدكتور دومينيك بيلون ، الأستاذ المساعد في قسم طب الأسرة في جامعة مونتريال ، الذي يرأس مكتب الاختبارات والشهادات في CCMFC: “يبدو أن الجهاز كان يعمل جيدًا”.